Информационные критерии используются для сравнения моделей с разным числом параметров, когда требуется выбрать наилучший набор объясняющих переменных. Данные критерии учитывают число наблюдений n и число параметров модели p и отличаются друг от друга видом «функции штрафа» за число параметров. Все критерии рассчитываются на основе логарифма функции правдоподобия LogL, что позволяет применять их к широкому спектру моделей.

Для информационных критериев действует правило: наилучшая модель имеет наименьшее значение критерия.

Критерий рассчитывается по формуле:

В отличие от критерия Акаике, критерий Шварца налагает больший «штраф» за использование дополнительных параметров:

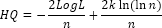

Данный критерий является ещё одной альтернативой критериев Акаике и Шварца:

См. также:

Библиотека методов и моделей | ISummaryStatistics.AIC | ISummaryStatistics.SC | ISummaryStatistics.HQcriterion